用数据视图搞信息共享,数据库怎么传过去才顺畅点

- 问答

- 2025-12-25 08:42:57

- 4

(来源:根据多位企业IT运维人员和项目负责人在技术社区的经验分享整理)

说到用数据视图搞信息共享,数据库怎么传过去才顺畅点,这个问题确实挺实际的,很多人觉得不就是把数据库复制一份过去吗?但真做起来,里面坑不少,搞不好就卡顿、出错,甚至把两边系统都搞乱,咱们就抛开那些高大上的专业术语,用大白话聊聊怎么才能让这个过程顺溜起来。

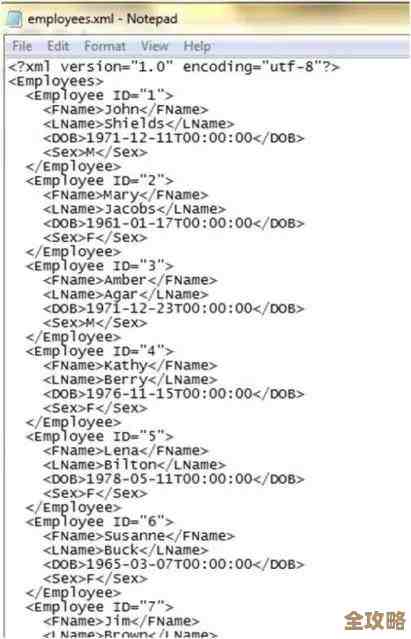

最傻但有时又不得不用的法子:直接导个文件传过去。 比如把整个数据库或者视图对应的数据导成一个巨大的SQL文件,或者CSV、Excel表格,这个方法听起来原始,但在数据量不大、共享频率很低(比如一个月才一次),而且两边网络环境还不错的情况下,它反而是最省事的,你不需要搭建复杂的同步工具,导出一个文件,用U盘、网盘或者直接发邮件(如果数据不敏感的话)扔给对方,对方在自己的数据库里一执行或者一导入,就完事了。(来源:某小型创业公司技术负责人分享的临时数据交付经验)但它的毛病也显而易见:数据一多,文件就巨大,传输耗时很长,容易中途失败;而且数据是“死”的”,是某个时间点的快照,对方拿到手的时候,你这边的数据可能已经更新了,信息不同步;万一导入过程中出点错,排查起来也麻烦,所以这只算是个权宜之计。

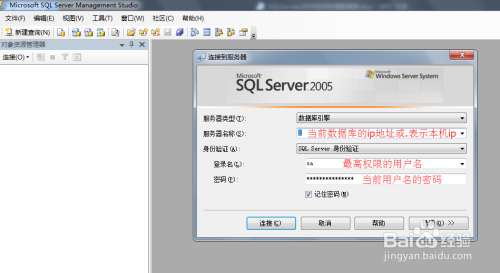

如果想比文件传输先进一点,自动化一点,可以考虑“数据库链接”这个东西。 你可以把它想象成在两个数据库之间拉一根“专线”,信息共享方(我们叫A库)不需要把数据真的复制出来,而是给数据使用方(我们叫B库)开一个访问权限,B库这边可以直接通过这条“专线”去查询A库里的那个数据视图,感觉就像在查自己库里的表一样。(来源:传统企业跨部门数据查询的常见做法)这样做的好处是,B库看到的数据永远是A库那边最新的,是“活”的,实现了实时或准实时的共享,而且因为数据没有副本,也避免了数据不一致的问题,但这条“专线”的顺畅度,非常依赖网络质量,如果两个数据库所在的服务器网络延迟高、带宽小,或者跨了公网不太稳定,那么B库的查询速度就会很慢,甚至经常超时断开,万一A库那边压力大,B库的查询还可能影响到A库本身的性能,所以用这个方法,得确保网络这条“路”又宽又稳。

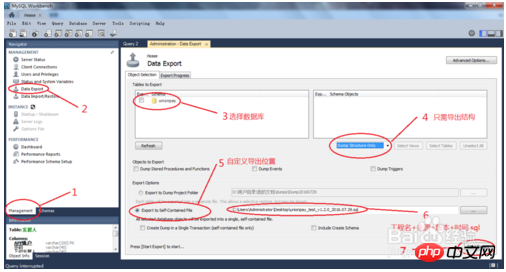

对于需要定期、增量更新的场景,上面两种方法可能都不太理想,这时候“定时同步”的思路就上场了。 核心思想是,别一次性传全量数据,只传上次同步之后变化的那部分,你可以写个脚本,每天夜里业务不忙的时候,自动去扫描数据视图,找出今天新增加的、或者修改过的记录,然后把这一小撮数据导出,再传到对方数据库里去增量更新。(来源:某电商平台与数据分析部门间的每日数据同步方案)这个方法大大减少了每次传输的数据量,速度快,对网络的压力小,也能保证数据在一天之内是相对同步的,实现起来可以用数据库自带的工具(比如一些数据库的发布订阅功能),也可以用一些开源的ETL工具来配置任务,它的顺畅度关键在于找准“增量”的方法,比如依靠时间戳字段或者自增ID来判断哪些数据是新的,缺点是毕竟不是实时同步,总会有一段延迟。

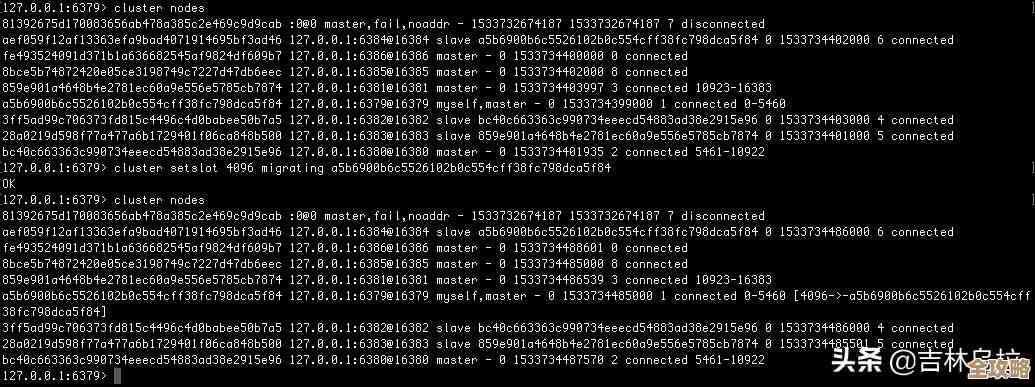

如果要求更高,希望数据变化能几乎实时地传过去,那就得用上“监听变化”的机制了。 有些现代的数据库支持一种叫“变更数据捕获”(CDC)的功能,简单说,就是数据库会把自己身上任何数据的增删改操作都记录下来,像写日记一样,可以有一个程序一直盯着这本“日记”,只要一有新的变化记录,就立刻抓取这个变化的内容,并把它发送到目标数据库。(来源:互联网公司实现微服务间数据实时同步的技术选型讨论)这就好比给数据装上了“直播”功能,这边一动,那边几乎同时就能看到,这种方式能最大程度保证数据的实时性和一致性,传输的数据量也是最小的(只传变化量),但要搭建和维护这套“直播”系统,技术复杂度是最高的,对数据库版本和配置有要求,也需要开发或部署专门的数据采集和传输程序,顺畅与否取决于这个“直播管道”的稳定性和处理速度。

回到“怎么传过去才顺畅点”这个问题,没有唯一答案,得看你的具体需求:

- 看数据量和频率: 数据小、频率低,文件传输可能最顺畅,数据大、要定期更新,定时同步更顺畅,要求实时,就得考虑CDC。

- 看网络条件: 网络好,数据库链接可能直接解决问题,网络差,就得靠增量同步来减少传输负担。

- 看技术能力: 团队技术力量强,能搞定复杂的CDC管道,那就能实现最极致的顺畅,如果技术资源有限,那么选择一个简单可靠的定时脚本,反而能保证长期运行的顺畅和稳定。

顺畅的关键在于“匹配”,选择那个最适合你当前数据特点、网络环境和技术团队能力的方法,而不是一味追求最先进的技术,最简单的方法反而是最顺畅、最不容易出错的。

本文由邝冷亦于2025-12-25发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/68066.html