存储过程来搞定数据库里那些重复数据,省事又高效的去重方法分享

- 问答

- 2025-12-23 19:29:06

- 3

综合自多位资深数据库开发人员的实践经验分享及技术社区常见解决方案)

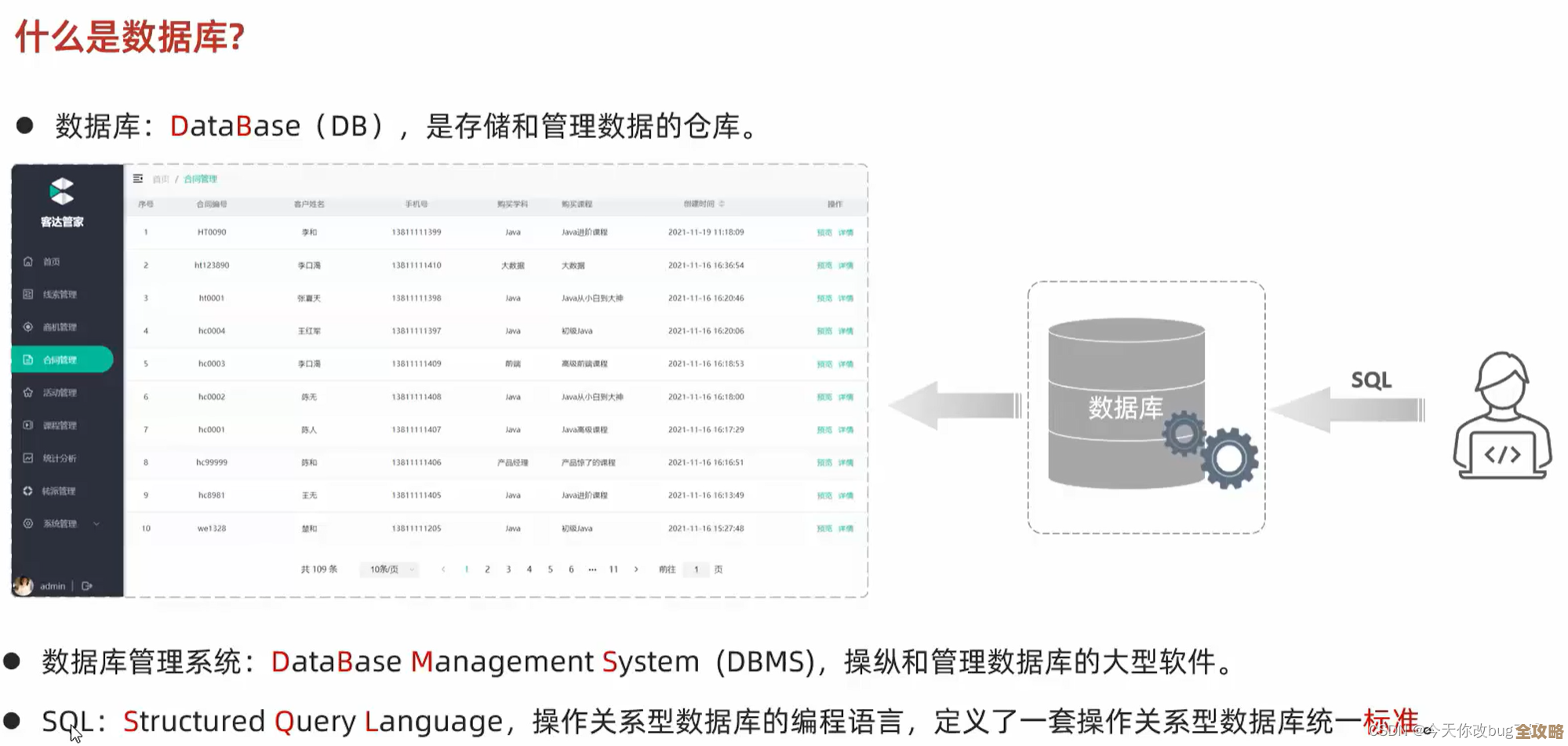

今天咱们来聊聊一个让很多搞数据库的朋友头疼的问题——怎么处理那些像野草一样,春风吹又生的重复数据,手动一条条找、一条条删?那太慢了,而且容易出错,用一些临时工具?下次数据多了又来一遍,不治本,这里给大家分享一个省事又高效的法宝:用存储过程来搞定它。

咱们得搞清楚,什么样的数据算重复?就是那些不应该一样却完全一样的记录,一个用户表,按理说手机号或者身份证号应该是唯一的,但可能因为系统bug或者人工导入错误,同一个人出现了两次甚至多次,我们的目标就是,在众多重复中,保留一条“种子”记录,把那些“山寨版”清理掉。

为啥要用存储过程呢?你想啊,去重这个事儿,往往不是一次性的,只要数据还在不断录入,就可能因为各种原因再次产生重复,存储过程就像是你写好的一个自动化脚本,把复杂的判断逻辑和删除步骤都封装起来,下次再出现类似问题,你只需要简单地调用一下这个“神器”,敲一行命令,它就自动帮你把活儿干了,省去了每次都要重新想步骤、写复杂SQL的麻烦,这对于需要定期清理数据的维护任务来说,尤其方便。

具体怎么用存储过程来实现呢?咱们来一步步拆解,核心思路其实不复杂:我们要找到一个标准来判断哪些行是重复的,这个标准可能是一个字段,比如邮箱;也可能是多个字段的组合,姓名+电话+住址”,确定了这个“重复键”之后,我们就可以开始行动了。

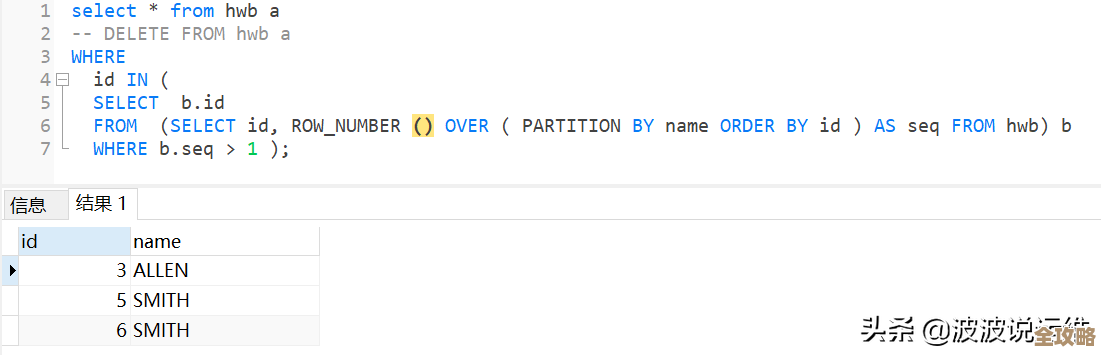

一个非常经典且实用的方法是利用窗口函数(比如ROW_NUMBER()),这个函数的功能是给查询出来的每一行编个号,我们可以让它针对我们认定的重复数据组(比如所有邮箱相同的记录为一组)内部进行编号,怎么编呢?我们可以按照某个顺序,比如按照数据创建的时间倒序排,给每组里的第一条记录编为1,第二条编为2,以此类推。

有了这个编号,事情就简单多了,我们的存储过程就可以这样设计:它会把所有重复的数据组找出来,并且为每一行都标上这个组内序号,它的任务就变成了一个简单的删除操作:删除所有组内序号大于1的记录(也就是每组里面重复的、非第一条的记录),这样,最终保留下来的,就是每个重复组里的“第一条”数据,达到了去重的目的。

实际编写存储过程的时候,我们还得考虑得更周全一些,为了避免在操作过程中影响正常的业务查询,我们可能会选择在一个事务里进行操作,这样万一出了问题可以回滚,又比如,对于数据量特别大的表,直接操作可能会锁表很久,影响性能,这时候,我们可以耍个小聪明,不直接删除,而是先把要保留的那些记录的ID找出来,然后反向删除那些不在保留列表里的重复记录,或者分批次处理,每次处理一部分数据,减小对数据库的压力。

为了增加存储过程的灵活性,我们还可以把它设计得“聪明”一点,把判断重复的字段名、按照哪个字段排序(是保留最新的记录还是最老的记录)作为参数传进去,这样,一个存储过程就能应对不同表的多种去重需求了,真正实现“一劳永逸”。

安全第一!在执行任何删除操作之前,尤其是这种大规模的清理,一定要先备份数据!这是铁律,你可以在存储过程里加入逻辑,先把要删除的数据记录到一个临时表或者日志表里,万一删错了,还有机会恢复,或者,更稳妥的做法是,先在测试环境用备份的数据跑一遍,确认没问题了,再在正式环境执行。

举个例子,假设我们有一个users表,怀疑email字段有重复,我们可以创建一个存储过程,叫RemoveDuplicateUsers,这个过程内部会使用类似这样的逻辑:给每个相同email的组按注册时间排序,只保留最早注册的那条,删除同组其他的,以后只要发现重复数据增长了,就执行一下EXEC RemoveDuplicateUsers,数据库就自动清理干净了。

面对数据库里的重复数据,别再手动折腾了,花点时间编写一个适合自己的存储过程,虽然前期需要动点脑筋,但一旦完成,它就成为了一个自动化、可重复使用的强大工具,能为你节省大量的时间和精力,让数据维护工作变得高效又省心,这种方法的核心优势在于它的自动化和可复用性,特别适合处理周期性出现的重复数据问题。

本文由符海莹于2025-12-23发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/67095.html