服务器内存技术演进图谱:迈向未来存储巅峰的革新之路

- 问答

- 2025-09-21 18:06:29

- 1

迈向未来存储巅峰的革新之路

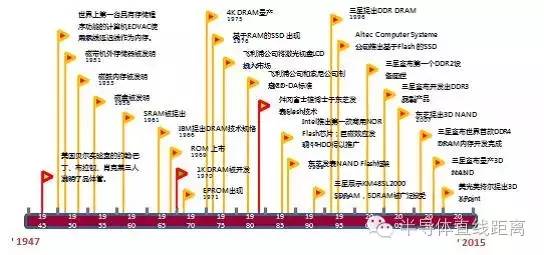

从SDRAM到DDR5:一场速度与容量的马拉松

还记得2000年初那会儿,服务器内存还在用SDRAM吗?😅 那时候128MB都算高配,现在想想简直像石器时代,后来DDR(Double Data Rate)技术横空出世,内存带宽直接翻倍,企业级应用才开始真正起飞。

但DDR的进化可不是一帆风顺的,DDR2到DDR3的过渡期,厂商们疯狂堆频率,结果功耗爆炸💥,散热成了噩梦,我还记得某次数据中心巡检,一排服务器因为内存过热集体宕机,运维小哥脸都绿了……

到了DDR4,总算在能效比上找回点面子,但真正的大招还得是DDR5,2021年Intel Sapphire Rapids首发支持DDR5-4800,带宽直接比DDR4翻倍!不过嘛,初期价格贵得离谱,很多企业还在观望——毕竟技术再牛,也得考虑ROI(投资回报率)对吧?

非易失性内存(NVM):打破冯·诺依曼瓶颈的野望

传统DRAM再快,断电数据就没了,所以NVM(非易失性内存)成了新宠,Intel的Optane Persistent Memory(傲腾)曾经被寄予厚望,号称能“模糊内存和存储的界限”……结果2023年突然宣布停产,业界一片哗然🤯。

说实话,Optane技术本身很酷,但成本太高,生态也没跟上,相比之下,三星的CXL(Compute Express Link)内存扩展方案反而更务实,通过PCIe通道让内存池化,灵活度拉满,不过CXL现在还在早期阶段,兼容性问题一堆,我测过几个demo,延迟波动大得像过山车🎢……

内存计算(In-Memory Computing):让数据跑得更近

AI和大数据时代,传统“CPU→内存→存储”的架构越来越像堵车的高架桥🚗💨,于是HBM(高带宽内存)和PIM(存内计算)开始冒头。

HBM最早是给GPU用的(比如NVIDIA的H100),但现在也渗透进服务器领域,AMD的EPYC 9004系列就支持HBM3,直接把内存带宽怼到TB/s级别!不过HBM的缺点是……贵到离谱,而且良率低,台积电的CoWoS封装产线都快被挤爆了😵。

PIM(Processing-in-Memory)更激进,直接在内存颗粒里塞计算单元,美光的3D XPoint曾经想搞这个,可惜凉了,现在韩国KAIST和SK海力士在搞的MRAM(磁性内存)有点意思,但离商用还远着呢……

量子内存?光计算?还是另辟蹊径?

最近总有人问我:“量子内存是不是下一代革命?”🤔 理论上,量子比特(Qubit)能同时存0和1,但现在的量子计算机还在用-273°C的冰箱(稀释制冷机)当“内存”,离实用化差了十万八千里……

更现实的可能是光子内存,用光脉冲代替电信号,IBM和MIT都在研究,但光器件集成度太低,实验室里跑得欢,一出门就趴窝🌚。

技术没有银子弹,只有不断试错

回头看内存技术的演进,像极了打游戏通关——每次以为找到终极答案,下一秒就被新需求打脸😅,DDR5、CXL、HBM这些技术不会谁彻底取代谁,而是会长期共存,在不同的场景里找最优解。

至于未来?或许某天我们会用上DNA存储(微软已经在玩了),或者直接脑机接口插内存条(开玩笑的……大概吧),但无论如何,这场存储巅峰之战,注定充满意外和惊喜。

(PS:最近在折腾一台老服务器升级DDR4,发现插槽居然不兼容……暴躁中🙃)

本文由帖慧艳于2025-09-21发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/5618.html