Unicode编码转换实战解析:提升数据处理效率的关键策略

- 问答

- 2025-10-24 22:06:29

- 3

哎,说到Unicode编码转换,这玩意儿真是让人又爱又恨,记得有次我处理一个从老系统导出的CSV文件,打开一看,满屏都是像“ä½ å¥½”这种鬼画符,当时头皮都麻了,你可能会想,这不就是UTF-8没正确解码嘛,但问题在于,数据源本身标注的是“GBK”,实际却混了UTF-8的字符——像一场编码界的“身份错位”剧。

其实Unicode本身是个伟大的发明,它试图把全世界的文字都塞进一个大家庭,但现实是,数据在流转中总被折腾得面目全非,比如有时你从网页抓取数据,明明页面显示正常,但一到脚本里就变成乱码,这时候,光靠decode('utf-8')可能反而会炸出一堆UnicodeDecodeError,就像用钥匙开错了门,还硬拧,结果锁芯卡死了。

有个挺邪门的案例:某次我遇到一个文件,用常规的chardet库检测编码,结果返回的是“ISO-8859-1”,但实际内容里掺了韩文字符——这检测工具居然摆烂了!后来发现,是因为文件开头有几个字节的BOM头(Byte Order Mark),但中间又被人用文本编辑器删改过,导致编码信号混乱,这种时候,就得像侦探一样,先hexdump看二进制,再手动试几种编码组合,甚至得靠猜:比如如果乱码中频繁出现“é”这类字符,很可能是UTF-8被误读成了Latin-1。

说到策略,最笨的方法反而最可靠:逐层试错,先尝试用errors='ignore'忽略无效字节,再看剩余文本是否合理;或者用surrogateescape模式把异常字节保留下来,后期再修复,但要注意,有些错误就像埋在地下的水管漏水,表面看着没事,一加压就崩,比如曾经有个项目,因为一个隐藏的零宽度空格(U+200B)在转换时被处理成问号,直接导致下游API校验失败——这种坑,debug两小时才揪出来,简直想给电脑浇杯咖啡提神。

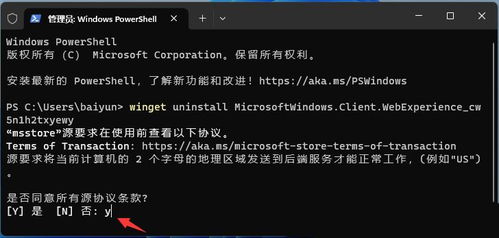

自动化工具能省力,但别迷信,有次我写了个脚本自动转码,结果因为系统区域设置是中文环境,Python默认用的编码居然是GBK,导致处理英文文档时把正常ASCII字符也转出乱码,后来学乖了,强制在脚本开头声明# -*- coding: utf-8 -*-,甚至显式指定open(encoding='utf-8'),不过话说回来,编码问题就像天气,你以为带了伞,结果下的是冰雹。

最后扯个题外话:有些开发者会暴力统一用UTF-8,但遇到老旧系统输出的GB2312文件,可能直接转码会丢失生僻字。𠮷”(注:这个字其实不在GB2312范围)这种字,一旦被强行转换,就可能变成“?”——像被拍扁的昆虫,再也还原不回原貌,有时候“提升效率”反而意味着得慢下来,先做编码勘探,再动手。

处理Unicode就像收拾一团毛线,你得耐心找到线头,偶尔还得接受某些结根本解不开,只能剪掉重来,但越是混乱的场景,越需要那种“哦,原来是这样!”的顿悟时刻——虽然这种时刻,往往伴随着加班和咖啡因过量。

本文由凤伟才于2025-10-24发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/42394.html