深入解读dr含义:专业视角下的概念解析与实际应用指南

- 问答

- 2025-09-30 18:21:54

- 1

深入解读DR含义:当服务器炸成烟花时,我的血泪教训与生存指南

凌晨三点,刺耳的手机警报声把我从浅眠中硬生生拽出来,屏幕上是运维同事发来的消息:"核心数据库主节点挂了,备节点同步失败,业务全停!" 💥 那一刻,我穿着睡衣冲进书房,手抖着连上VPN,脑子里只有一个念头:我们的DR(灾难恢复)计划,纸上谈兵的东西,真能救命吗?那次长达8小时的业务中断,客户投诉像雪片一样飞来,老板铁青的脸,成了我对DR最刻骨铭心的"启蒙教育"——它绝不只是IT部门文档柜里落灰的几页纸。

DR:远不止"备份"那么简单!揭开概念的"里子"

- 核心要义: 说穿了,DR就是你的"数字诺亚方舟"计划,它回答一个生死攸关的问题:当你的数据中心被水淹了(字面或比喻)、被黑客勒索了、甚至只是某个工程师手滑敲了致命命令,你的关键业务系统多久能爬起来?爬起来后数据能追回多少?🤔

- 经典误区大扫雷:

- "我们有备份=我们有DR"? 天真了!备份只是把数据存了个副本,就像把重要文件锁进保险箱,但DR是确保你在房子烧毁后(灾难发生),能迅速在别处重建一个家(恢复业务),并且保险箱里的文件(数据)能及时拿出来用,那次凌晨宕机,我们是有备份,但恢复脚本过时了,新业务模块根本没覆盖到,恢复过程磕磕绊绊,痛苦翻倍。

- "RTO/RPO?字母组合而已"? 这两个指标是DR的灵魂!RTO(恢复时间目标) 是你业务能忍受的最大停机时间——是1小时?4小时?还是24小时?这直接决定了你要花多少钱!RPO(恢复点目标) 是你最多能丢多少数据——是5分钟前的?1小时前的?还是昨天的?我见过一个电商客户,因为RPO设得太宽松(允许丢1小时数据),大促时故障,直接损失了百万订单,市场部同事差点集体崩溃。🩸

- "DR方案一步到位?" 别做梦了!DR是个持续烧钱、持续优化的过程,技术更新、业务扩张、威胁变化,都逼着你不断调整,就像我现在的公司,三年前觉得异地冷备够用了,去年上了云,今年又因为合规要求,不得不搞成双活多AZ部署,预算表看得财务总监直捂心口。

纸上谈兵?看看这些"翻车"与"高光"现场

-

反面教材:某本地生活服务商的血泪史 他们早期业务量小,DR方案极其"朴素":每周一次全量备份到移动硬盘,由运维小哥下班带回家保管(是的,真事!😅),结果某次机房空调故障导致服务器过热宕机,硬盘损坏,试图恢复时发现:

- 上周的备份硬盘...小哥休假带出去旅游弄丢了!

- 再上次的备份,已经是一个月前的数据。

- 恢复过程缺乏文档,手忙脚乱。 后果:丢失近一个月订单和用户数据,口碑暴跌,几乎被市场淘汰,教训:没有异地、没有自动化、没有验证、没有明确职责的DR,等于没有DR。 移动硬盘带回家?这方案浪漫得让人心碎。

-

正面案例:某金融科技公司的"教科书"级操作 深知金融业务中断的致命性,他们肯在DR上砸钱:

- 架构: 基于主流公有云,实现真正的跨区域双活,业务流量平时就分摊在两个区域跑,一个区域挂了,流量秒级切到另一个区域,用户几乎无感(RTO分钟级),数据强一致性同步(RPO≈0)。

- 演练: 不是演戏,是玩真的! 每季度一次"灾难日",随机时间,由高管(非IT!)抽签决定"摧毁"哪个区域的核心服务,IT团队在不知情的情况下启动恢复,演练后复盘极其严苛,甚至计入KPI,第一次演练,恢复超时2小时,整个团队季度奖金泡汤,从此没人敢怠慢。

- 自动化: 从故障检测、告警、到切换、验证,高度自动化脚本覆盖,人工干预点极少,减少慌乱出错,他们运维总监的名言:"好的DR,应该像心脏起搏器,关键时候自动工作,别指望人能在高压下不出错。"

搞DR?别踩坑!我的实战生存手册

-

老板,这不是成本,是保险费!💰

- 算清账: 别光看买多少服务器、付多少云服务费,算算业务中断一小时损失多少钱(收入、客户、罚款、股价...),把这份"疼痛报告"拍在老板桌上,比技术方案PPT管用一百倍,当年我拿着估算的每分钟损失金额去找大老板,预算批复快多了。

- 分级保护: 不是所有业务都值得双活!分清核心命脉业务(必须高RTO/RPO)和边缘业务(允许较长恢复时间),集中资源保重点,比如核心交易系统必须双活,内部报销系统?冷备也许就够了。

-

演练!演练!演练!重要的事说三遍!

- 真刀真枪: 别搞"桌面推演"自欺欺人,模拟真实灾难场景,断网、断电、删库(在安全环境!),看团队如何反应,流程是否顺畅,文档是否有效,第一次真演练时,我们发现紧急联络人名单里还有离职半年的同事电话,尴尬到脚趾抠地...

- 全员参与: 业务部门、客服、公关都要参与!灾难时他们才是直面客户怒火的第一线,让他们知道流程,知道何时、如何发布公告,演练时模拟客户投诉,看客服话术是否到位,公关稿是否及时,那次演练,客服部抱怨信息传递太慢,倒逼我们改进了内部通告机制。

-

拥抱云,但别当甩手掌柜!☁️

- 云不是万能药: 云服务商确实提供强大基础设施(多AZ、异地复制),但责任共担模型要搞清!云商保平台,你保自己的应用、数据、配置和恢复流程,别以为上了云就高枕无忧,应用层配置错误导致恢复失败的例子比比皆是。

- 多云/混合云是趋势: 鸡蛋别放一个篮子,考虑利用不同云商,或者混合云(自建+公有云)做DR,避免被单一供应商"绑架"或遭遇其区域性大故障,虽然管理复杂度飙升,但安全感也倍增。

-

人,才是最不可靠的环节?

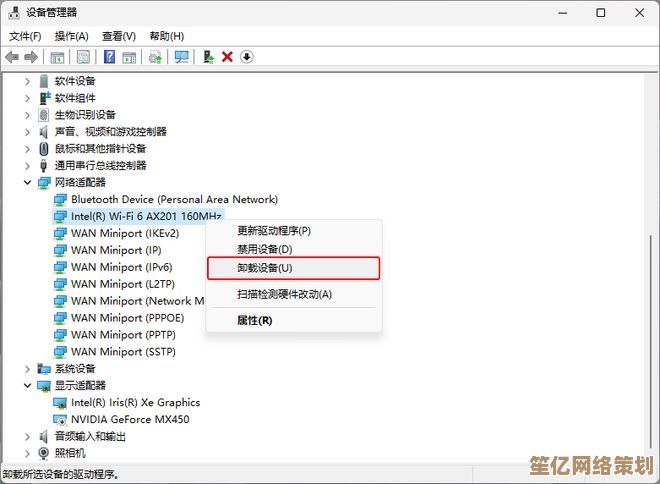

- 文档要"弱智"也能看懂: 灾难发生时,可能是一线初级工程师在操作,文档必须清晰、步骤化、无歧义,最好带截图!避免"联系相关人员"这种模糊描述,直接写名字和电话!我们吃过亏,文档写"联系DBA",结果半夜值班的新人不知道谁是DBA...

- 权限与备份: 确保关键恢复账号(高权限!)的密码安全且多人知晓(但需管控),这些账号的权限也要备份!别灾难发生时,唯一有权限的人联系不上,或者权限配置本身在灾难中丢失了... 别笑,真发生过!

本文由黎家于2025-09-30发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/15045.html