如何应对脚本运行中断?小鱼教您详细步骤恢复操作顺畅

- 问答

- 2025-09-30 05:16:56

- 1

脚本崩了别砸键盘!😭 小鱼血泪史教你绝地求生

凌晨两点,屏幕突然一暗,我盯着那个冰冷的 Killed 提示,和爬了80%却戛然而止的20万条数据,感觉心脏被一只无形的手攥紧了。💔 咖啡杯在桌角晃了晃——不是地震,是我砸键盘的余震,这破脚本,又在最关键的时刻摆了我一道!

别问我怎么知道的,这种痛,每个深夜鏖战的码农都懂。 但砸键盘除了让钱包哭泣(以及吵醒邻居),毫无意义,今天掏心窝子分享几条从无数次“猝死”中爬出来的野路子,没有教科书般的完美,只有滚钉板似的真实。

🛟 第一步:救命稻草!先别关终端!(血的教训)

那次我本能地 Ctrl+C 想终止错误输出,结果...把整个终端关了!😫 半天的计算全泡汤。脚本崩了,终端窗口就是你的战地医院! 哪怕满屏飘红,也先别动它:

- 疯狂截图/复制最后几十行日志:

Scroll Lock键是神器,或者直接鼠标拖选复制,那次内存泄漏,就是靠截图里一个不起眼的MemoryError翻的盘。 - 试试

fg命令:万一它只是被挂起(比如你误按了Ctrl+Z)?死马当活马医,敲一下不亏。

📚 第二步:翻“病历本”——日志不是摆设!

有次爬虫莫名卡死,日志里只有 Connection reset,我骂咧咧准备重跑,同事老张眯眼指着日志里 每隔5分钟就重复一次的 Retrying... (attempt 3 of 10):“小鱼,你这脚本,怕不是在死循环里跟人家网站较劲呢?” 😳 真相:网站反爬升级,我的重试逻辑成了自杀循环! 改成了指数退避才活过来。

日志要这么啃:

- 倒着读! 崩溃瞬间的线索往往在最后,那次

KeyError报错,往前翻三行发现是个空列表推导——源头是上游API偷偷改了返回结构! - 搜关键词:

Error,Exception,Traceback,Killed,core dumped... 别被吓到,它们是路标。 - 看时间戳:突然密集报错?可能是外部依赖挂了(比如第三方API抽风,那次用某地图服务,脚本崩了才发现他们发公告在维护!🤦♀️)。

🧩 第三步:分段执行,别头铁硬刚!

处理200万条用户数据清洗?我试过一晚上跑三次,三次都在凌晨崩于不同阶段... 绝望中我把脚本大卸八块:

# 原版(作死版) process_huge_data(all_users) # 分尸存活版 ✅ chunk1 = all_users[:500000] process_huge_data(chunk1) # 存中间结果! chunk2 = all_users[500000:1000000] process_huge_data(chunk2) # 再存! ... # 以此类推,最后合并

虽然土,但真能救命! 尤其处理不可控的外部资源(网络、大文件),分段就是你的安全气囊,那次清洗,第三个分块果然又遇网络波动,但因为只丢了50万条而不是200万,我甚至能笑着重试。😌

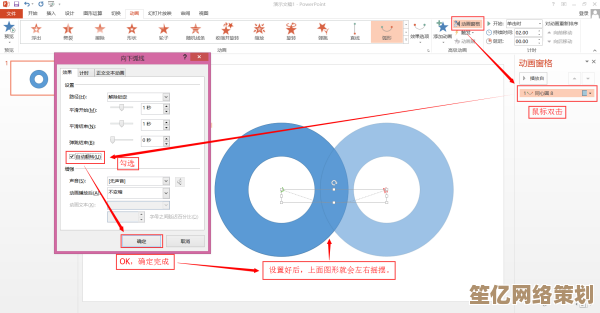

⏳ 第四步:给脚本戴上“健康手环”——超时与心跳

调用一个外部API,默认它永远乖巧?太天真!那次脚本“假死”一晚上,早上才发现卡在一个第三方服务无响应的请求上。必加超时!

import requests

try:

# 等10秒还不回?直接抛异常走人!

response = requests.get('https://脆皮API.com/data', timeout=10)

except requests.exceptions.Timeout:

log.error("API大爷又躺平了!记入黑名单,跳过!")

continue

复杂长任务?加“心跳”:在循环里定期打印进度或写状态文件,就算崩了,你也知道它“死”在哪一步,不用从头再来,想象一下,跑了一夜的模型,崩了却不知道是epoch 10还是epoch 100崩的... 那感觉,想死。

🧪 第五步:拥抱“脏数据”,别追求无菌室!

我写过“完美”的数据清洗脚本,遇到一个字段缺失就怒抛 ValueError 罢工,结果?现实数据脏得像泥坑,脚本跑得比蜗牛还慢,还老中断。后来学乖了:

for record in dirty_data:

try:

clean_record = complex_cleaning(record) # 可能爆炸的清洗

except (KeyError, TypeError, ValueError) as e:

log.warning(f"记录 {record['id']} 洗坏了!原因: {e}. 标记为脏数据跳过")

dirty_list.append(record) # 先记下来!

continue # 别让它炸了整个流水线!

clean_data.append(clean_record)

# 跑完了!再集中处理脏数据,或扔给人工

save_problem_children(dirty_list)

容忍不完美,才能跑完全程。 先拿到90%的干净数据,比因为10%的脏数据而卡死0产出强一万倍!那次之后,我交付速度快了,客户反而夸我“能处理复杂情况”。🤷♀️

🌈 最后唠叨:备份!备份!还是备份!

你以为分段执行就稳了?我有个脚本,分段跑完第4块,高兴地去合并... 结果手滑 rm -rf 把整个输出文件夹送走了!🎉 眼前一黑不是形容词... 任何中间文件落地,下一秒必同步备份到云端或另一块硬盘。 rsync 是我的再生父母。

脚本如人生,中断是常态,崩溃时深吸口气,别跟机器赌气(它又不会哭),用这些带着毛刺的土方法,攒下自己的“生存指南”,下次再崩,你大概会像我一样,淡定地抿口咖啡:“小样,又来了?看爷怎么拿捏你。” ✨

小鱼心法:代码可以中断,但解决问题的韧性不能掉线,每一次从崩溃中爬起,都在你指尖刻下看不见的盔甲。

本文由水靖荷于2025-09-30发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://waw.haoid.cn/wenda/14480.html